很可惜 T 。T 您现在还不是作者身份,不能自主发稿哦~

如有投稿需求,请把文章发送到邮箱tougao@appcpx.com,一经录用会有专人和您联系

咨询如何成为春羽作者请联系:鸟哥笔记小羽毛(ngbjxym)

作者|吃货第一名的Claire

吐血整理数据人常用Pandas数据清理(附代码)

全文干货,阅读请自备奶茶解渴(wink)。

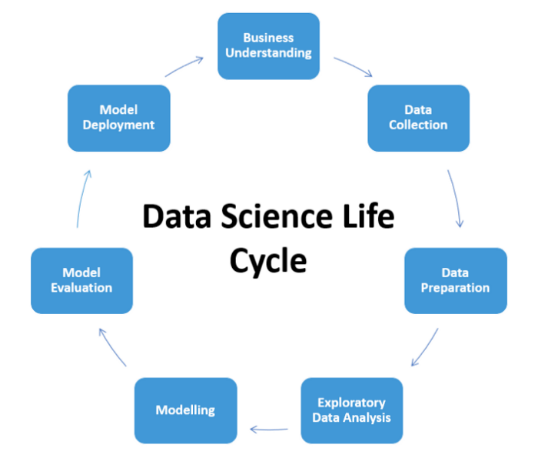

数据行业的从业者都知道数据清理是整个数据分析周期(见下图)最重要也是最耗时的步骤。没有“干净”的、符合特定规范的数据输入,就没有有效的结果引导决策,更糟糕的是,数据清理不完整或者错误甚至会误导决策,GIGO (garbage in, garbage out)就是我们数据人最想避免的情况。

Source: Quora

备注:The step of data preparation is also known as Data Cleaning or Data Wrangling。

这篇文章是我通过工作中处理大几十个公司的数据遇到的问题而做的总结,问题都源于工业界实际应用案例,大家可以当作备考、面试、工作的cheat sheet,还不快点赞收藏~

此处附有GitHub代码:请自行下载。

https://github.com/ClaireWithGithub/pandas_data_cleaning/blob/main/data_cleaning_github_08052021.ipynb

本文的方法都尽量致力于用最短的代码、最快的运行速度来解决问题,当然,如果有更好的方法欢迎大家留言。

建议:阅读code前,大家可以先想想当你们遇到这些问题会怎么写,先思考再“抄作业”看解析,印象会更加深刻哦。

Note:数据清理好习惯 - 代码run完,记得要double check清理结果。

完整代码:

df = pd.DataFrame()

# the glob module is used to retrieve files/pathnames matching a specified pattern

dir_filenames = sorted(glob('./*.xlsx')) # all excel files from current directory

for dir_file in dir_filenames:

dict_xlsx = pd.read_excel(dir_file, sheet_name=None)

workbook = pd.concat([v_df.assign(Sheet = k) for k,v_df in dict_xlsx.items()], ignore_index=True)

df = pd.concat([df,workbook],ignore_index=True)

print(f'shape of merged files:{df.shape}')

解析:总体思路是读取每个工作簿,再读取每个工作簿的工作表,list comprehension内循环合并表,外循环合并工作簿

glob用于返回符合某个pattern的路径和文件名glob('./*.xlsx') 返回当前目录下的所有Excel文件名

python的built-in function sorted()不改变原list,要赋值给新的variable才实现排序

pd.read_excel(dir_file, sheet_name=None) 返回dictionary,key是sheet name, value是工作表的数据

[v_df.assign(Sheet = k) for k,v_df in dict_xlsx.items()]是list comprehension,通常能简化代码的同时加快代码的运行速度

df.assign()是新加一列,记录工作表名称

pd.concat([])是纵向合并数据的好方法完整代码:

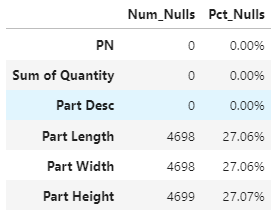

count_null_series = df.isnull().sum() # returns series count_null_df = pd.DataFrame(data=count_null_series, columns=['Num_Nulls']) # what % of the null values take for that column pct_null_df = pd.DataFrame(data=count_null_series/len(df), columns=['Pct_Nulls']) null_stats = pd.concat([count_null_df, pct_null_df],axis=1) null_stats

结果:

解析:df.isnull().sum()会算出每列缺失值的数量,再算一个缺失值占本列的百分比可以让自己更清楚数据的情况和下一步如何清理缺失值。

处理缺失值:

- 时间序列的数据常用df[col_name].fillna(method="ffill",inplace=True),ffill表示按上一个值填充

- 不同列补不同的值df.fillna(value={col1:50, col2:67, col3:100}, inplace=True)

- 以当列的平均值弥补空值df.where(pd.notna(df), df.mean(), axis="columns", inplace=True)

- 任意选定的列为空就删除该行df.dropna(subset=subset_list, inplace=True)

- 当一半的行为空,删除该列df.dropna(thresh=len(df)*N, axis=1, inplace=True)有没有小伙伴像我一样,当数据有很多无关不重要的列,而不愿意copy paste列名去drop的童鞋,这里提供用column index一行搞定删除多列的问题。

完整代码:

df.info() df.drop(df.columns[start_ind:stop_ind],axis=1,inplace=True) df.info()

当列很多的时候,每个column对应的index一个个数可太麻烦了,df.info()是一个非常简洁又高效的方法。他会返回dataframe的行数,列数,列名对应的index,数据类型,非空值和memory usage。

所以第一个df.info()就是为了找出你要删的列明的起始index和终止index,注意,如果你要删2-4列,stop_index应该是5才会把第4列删掉。第二个df.info()是为了double check最后的数据列都是你想要的,如果还有要删列还可以循环进行这样的步骤。

完整代码:

df.rename(columns= {'Order_No_1':'OrderID','ItemNo':'ItemID'}, inplace=True)

# remove special characters from column name

df.columns = df.columns.str.replace('[&,#,@,(,)]', '')

# remove leading/trailing space and add _ to in-between spaces

df.columns = df.columns.str.strip().str.replace(' ','_')df.rename()是常见的改列名的方法,在这里想格外强调后两行代码,是批量格式化列名的“黑科技”。

note:数据工作中,文件命名的convention(约定习俗)是不留空格,要么加’_’,要么加’-‘,要么CamelCase,这同样适用于数据的列名命名,因为计算机不擅于处理/解析空格。

for c in ['OrderID','ItemID','Class']:

df[c] = df[c].astype('str')完整代码:

len_df = len(df)

len_drop = len(df.drop_duplicates(subset = subset_list))

len_diff = len_df-len_drop

print(f'difference of length:{len_diff}')

if len_diff>0:

dups = df.duplicated(keep=False).sort_values(by=sort_list)

df_drop = df.drop_duplicates(subset=subset_list, keep='last')解析:df.drop_duplicates(subset = subset_list)会返回基于指定列subset_list去重后的dataframe。如果发现有重复值,

df.duplicated(keep=False).sort_values(by=sort_list)这段代码可以让你有方向的进行比较,keep=False是保证重复值都展示出来的必备参数,sort_values()是保证重复值挨着出现,方便你接下来决策如何处理他们。以上代码列举了保留重复值最后一项的例子(keep='last')。

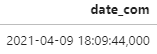

当我们收到了这样的数据,dtype是object,要如何把他转化成date format并且分离出time和hour呢?

代码:

# split by comma, retrieve the first column

df['date_com'] = df['date_com'].str.split(',', expand=True)[0]

# format要和原日期的格式一致,最后总会返回YYYY-MM-DD HH:MM:SS格式的datetime

df['date_com'] = pd.to_datetime(df['date_com'], format='%Y-%m-%d %H:%M:%S')返回结果:

如果要进一步分离date和time:

df['Date'] = df['date_com'].dt.date

dt_lst = df['date_com'].str.split(' ', n=1, expand = True)

df['Time'] = dt_lst[1]

# extract hour from Time

time_lst = df['date_com'].str.split(':', n=1, expand = True)

df['Hour'] = time_lst[0] #str今天的分享先到这里,感觉有学到新知识记得点赞转发加关注哦。下期见。

-END-

本文为作者独立观点,不代表鸟哥笔记立场,未经允许不得转载。

《鸟哥笔记版权及免责申明》 如对文章、图片、字体等版权有疑问,请点击 反馈举报

Powered by QINGMOB PTE. LTD. © 2010-2025 上海青墨信息科技有限公司 沪ICP备2021034055号-6

我们致力于提供一个高质量内容的交流平台。为落实国家互联网信息办公室“依法管网、依法办网、依法上网”的要求,为完善跟帖评论自律管理,为了保护用户创造的内容、维护开放、真实、专业的平台氛围,我们团队将依据本公约中的条款对注册用户和发布在本平台的内容进行管理。平台鼓励用户创作、发布优质内容,同时也将采取必要措施管理违法、侵权或有其他不良影响的网络信息。

一、根据《网络信息内容生态治理规定》《中华人民共和国未成年人保护法》等法律法规,对以下违法、不良信息或存在危害的行为进行处理。

1. 违反法律法规的信息,主要表现为:

1)反对宪法所确定的基本原则;

2)危害国家安全,泄露国家秘密,颠覆国家政权,破坏国家统一,损害国家荣誉和利益;

3)侮辱、滥用英烈形象,歪曲、丑化、亵渎、否定英雄烈士事迹和精神,以侮辱、诽谤或者其他方式侵害英雄烈士的姓名、肖像、名誉、荣誉;

4)宣扬恐怖主义、极端主义或者煽动实施恐怖活动、极端主义活动;

5)煽动民族仇恨、民族歧视,破坏民族团结;

6)破坏国家宗教政策,宣扬邪教和封建迷信;

7)散布谣言,扰乱社会秩序,破坏社会稳定;

8)宣扬淫秽、色情、赌博、暴力、凶杀、恐怖或者教唆犯罪;

9)煽动非法集会、结社、游行、示威、聚众扰乱社会秩序;

10)侮辱或者诽谤他人,侵害他人名誉、隐私和其他合法权益;

11)通过网络以文字、图片、音视频等形式,对未成年人实施侮辱、诽谤、威胁或者恶意损害未成年人形象进行网络欺凌的;

12)危害未成年人身心健康的;

13)含有法律、行政法规禁止的其他内容;

2. 不友善:不尊重用户及其所贡献内容的信息或行为。主要表现为:

1)轻蔑:贬低、轻视他人及其劳动成果;

2)诽谤:捏造、散布虚假事实,损害他人名誉;

3)嘲讽:以比喻、夸张、侮辱性的手法对他人或其行为进行揭露或描述,以此来激怒他人;

4)挑衅:以不友好的方式激怒他人,意图使对方对自己的言论作出回应,蓄意制造事端;

5)羞辱:贬低他人的能力、行为、生理或身份特征,让对方难堪;

6)谩骂:以不文明的语言对他人进行负面评价;

7)歧视:煽动人群歧视、地域歧视等,针对他人的民族、种族、宗教、性取向、性别、年龄、地域、生理特征等身份或者归类的攻击;

8)威胁:许诺以不良的后果来迫使他人服从自己的意志;

3. 发布垃圾广告信息:以推广曝光为目的,发布影响用户体验、扰乱本网站秩序的内容,或进行相关行为。主要表现为:

1)多次发布包含售卖产品、提供服务、宣传推广内容的垃圾广告。包括但不限于以下几种形式:

2)单个帐号多次发布包含垃圾广告的内容;

3)多个广告帐号互相配合发布、传播包含垃圾广告的内容;

4)多次发布包含欺骗性外链的内容,如未注明的淘宝客链接、跳转网站等,诱骗用户点击链接

5)发布大量包含推广链接、产品、品牌等内容获取搜索引擎中的不正当曝光;

6)购买或出售帐号之间虚假地互动,发布干扰网站秩序的推广内容及相关交易。

7)发布包含欺骗性的恶意营销内容,如通过伪造经历、冒充他人等方式进行恶意营销;

8)使用特殊符号、图片等方式规避垃圾广告内容审核的广告内容。

4. 色情低俗信息,主要表现为:

1)包含自己或他人性经验的细节描述或露骨的感受描述;

2)涉及色情段子、两性笑话的低俗内容;

3)配图、头图中包含庸俗或挑逗性图片的内容;

4)带有性暗示、性挑逗等易使人产生性联想;

5)展现血腥、惊悚、残忍等致人身心不适;

6)炒作绯闻、丑闻、劣迹等;

7)宣扬低俗、庸俗、媚俗内容。

5. 不实信息,主要表现为:

1)可能存在事实性错误或者造谣等内容;

2)存在事实夸大、伪造虚假经历等误导他人的内容;

3)伪造身份、冒充他人,通过头像、用户名等个人信息暗示自己具有特定身份,或与特定机构或个人存在关联。

6. 传播封建迷信,主要表现为:

1)找人算命、测字、占卜、解梦、化解厄运、使用迷信方式治病;

2)求推荐算命看相大师;

3)针对具体风水等问题进行求助或咨询;

4)问自己或他人的八字、六爻、星盘、手相、面相、五行缺失,包括通过占卜方法问婚姻、前程、运势,东西宠物丢了能不能找回、取名改名等;

7. 文章标题党,主要表现为:

1)以各种夸张、猎奇、不合常理的表现手法等行为来诱导用户;

2)内容与标题之间存在严重不实或者原意扭曲;

3)使用夸张标题,内容与标题严重不符的。

8.「饭圈」乱象行为,主要表现为:

1)诱导未成年人应援集资、高额消费、投票打榜

2)粉丝互撕谩骂、拉踩引战、造谣攻击、人肉搜索、侵犯隐私

3)鼓动「饭圈」粉丝攀比炫富、奢靡享乐等行为

4)以号召粉丝、雇用网络水军、「养号」形式刷量控评等行为

5)通过「蹭热点」、制造话题等形式干扰舆论,影响传播秩序

9. 其他危害行为或内容,主要表现为:

1)可能引发未成年人模仿不安全行为和违反社会公德行为、诱导未成年人不良嗜好影响未成年人身心健康的;

2)不当评述自然灾害、重大事故等灾难的;

3)美化、粉饰侵略战争行为的;

4)法律、行政法规禁止,或可能对网络生态造成不良影响的其他内容。

二、违规处罚

本网站通过主动发现和接受用户举报两种方式收集违规行为信息。所有有意的降低内容质量、伤害平台氛围及欺凌未成年人或危害未成年人身心健康的行为都是不能容忍的。

当一个用户发布违规内容时,本网站将依据相关用户违规情节严重程度,对帐号进行禁言 1 天、7 天、15 天直至永久禁言或封停账号的处罚。当涉及欺凌未成年人、危害未成年人身心健康、通过作弊手段注册、使用帐号,或者滥用多个帐号发布违规内容时,本网站将加重处罚。

三、申诉

随着平台管理经验的不断丰富,本网站出于维护本网站氛围和秩序的目的,将不断完善本公约。

如果本网站用户对本网站基于本公约规定做出的处理有异议,可以通过「建议反馈」功能向本网站进行反馈。

(规则的最终解释权归属本网站所有)